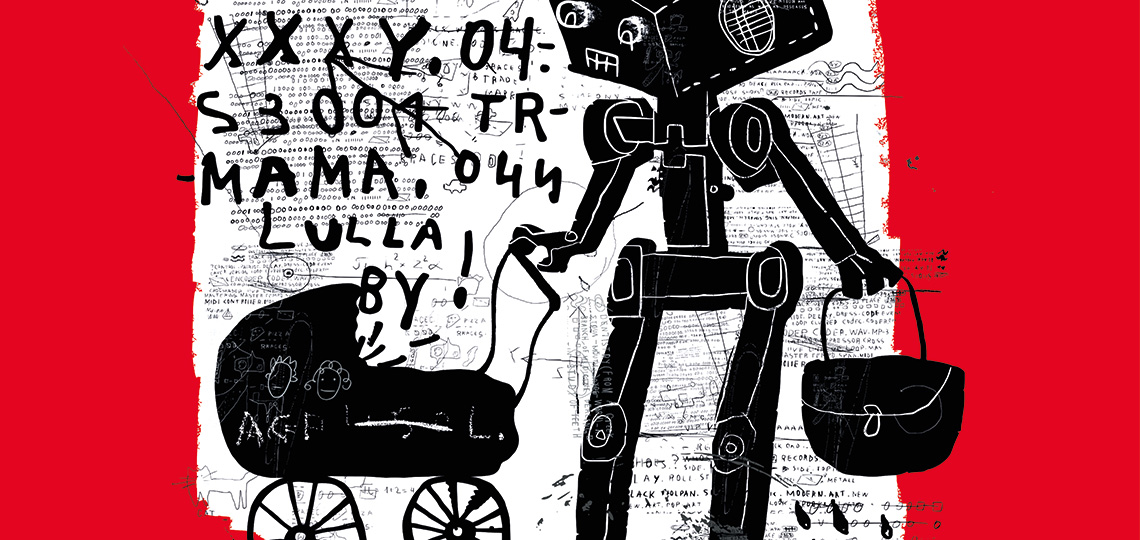

Die Forderung, Maschinen sollten moralisch werden, ist immer häufiger zu hören. Die Autoindustrie arbeitet mit Hochdruck an automatischen Fahrsystemen, die eine Ethik benötigen. Auch im Bereich des Militärs und der Pflege gibt es viele Anwendungsbereiche für Maschinen mit moralischen Fähigkeiten. Aber es gibt auch ethische Vorbehalte.

Text Catrin Misselhorn

Während die Entwicklung moralischer Maschinen auf der einen Seite auf Hochtouren läuft, stehen auf der anderen Seite viele Befürchtungen. Was bleibt von der menschlichen Einzigartigkeit, wenn Maschinen sogar moralisch sein können? Werden sie uns eines Tages womöglich ersetzen? Wie wird sich unsere moralische Praxis durch Maschinen verändern? Werden Maschinen eines Tages selbst moralische Rechte beanspruchen?

Diese Fragen gehören zum Bereich der Maschinenethik, einem neuen Forschungsgebiet an der Schnittstelle von Philosophie, Informatik und Robotik. Die Maschinenethik unterscheidet sich von anderen Formen der Technikethik, weil ihr Gegenstand die Entwicklung einer Ethik für Maschinen im Gegensatz zu einer Ethik für Menschen im Umgang mit Maschinen ist. Es geht darum, ob und wie man Maschinen konstruieren kann, die selbst moralische Entscheidungen treffen und umsetzen können, und ob man dies tun sollte. Analog zu „Artificial Intelligence“ (AI) spricht man auch von „Artificial Morality“ (AM).

Warum „Artificial Morality“?

Es gibt viele Arbeiten, die wir gerne Maschinen überlassen würden, weil sie zu schwer, gefährlich oder einfach unangenehm sind. In manchen Fällen gibt es auch nicht genügend Menschen, die sie übernehmen können und wollen. Schließlich können Maschinen manche Dinge auch einfach besser und schneller erledigen als Menschen. Dies kann jedoch nur gelingen, wenn Maschinen in der Lage sind, ihre Tätigkeiten weitgehend selbständig auszuüben. Was sie tun sollen, ist zwar einprogrammiert, aber die Ausführung erfolgt ohne permanente menschliche Kontrolle und Überwachung. Doch je intelligenter und selbständiger künstliche Systeme sind, desto eher werden sie in Situationen geraten, die moralische Entscheidungen verlangen.

Wie wichtig dieses Thema ist, zeigt sich beispielsweise an der großen Aufmerksamkeit, die mögliche Dilemma-Situationen beim autonomen Fahren in einer breiteren Öffentlichkeit erhalten haben. Was ist, wenn ein autonomes Fahrzeug ausschließlich die Möglichkeit hat, entweder einen Menschen am Ende seines Lebens oder ein kleines Kind zu töten? Was, wenn es nur dadurch fünf Menschenleben retten kann, dass es eine auf dem Gehweg stehende Person anfährt? Ist ein besonderer Schutz für die Insassen moralisch legitim oder kommt den anderen Verkehrsteilnehmern vom moralischen Standpunkt mehr Gewicht zu? Die Zukunft des autonomen Fahrens wird oft an die Lösung dieser Fragen geknüpft.

Auch für Medien und Meinungsbildung spielt Künstliche Intelligenz (KI) eine immer größere Rolle. Algorithmen bewerten und filtern Informationen. „Artificial Morality“ ist hier im Umgang mit problematischen Inhalten von Bedeutung, beispielsweise zur Erkennung von Hassreden, Nazi-Symbolen oder auch Kinderpornographie in sozialen Online-Netzwerken. Eine beeindruckende Zahl von KI-Forschern und Wissenschaftlern hat vor einiger Zeit in einem offenen Brief hervorgehoben, dass die Maschinenethik eines der wichtigsten und drängendsten Forschungsgebiete der KI ist.

Während vielfach das Gespenst einer „Superintelligenz“, die die Weltherrschaft übernimmt, an die Wand gemalt wird, sind die echten Gefahren viel naheliegender. Sie entstehen durch die Unvorhersehbarkeit des Verhaltens künstlicher Systeme und den Mangel an Kontrolle, die die Verantwortungszuschreibung erschweren, wenn etwas schiefgeht. So machte die Lufthansa geltend, der Konzern habe nach der Pleite von Air Berlin die Ticketpreise nicht bewusst erhöht, sondern das liege an der automatischen Software, verantwortlich seien also die Algorithmen. Solche Argumentationsstrategien sind hinfällig, wenn sichergestellt wird, dass stets Menschen die Verantwortung für das Tun der Maschinen übernehmen.

Verantwortung der Programmierer

Dabei muss darauf geachtet werden, dass solche Zuschreibungen nicht nur rechtlich abgesichert, sondern auch moralisch begründet sind. So könnte man die Nutzer dazu verpflichten, die volle Verantwortung für ein künstliches System bei Inbetriebnahme per Knopfdruck zu übernehmen. Doch das wäre unfair, denn zumindest ein Teil der Verantwortung, wenn nicht sogar der Hauptteil, sollte doch den Programmierern zukommen, deren Algorithmen ausschlaggebend für das Handeln des Systems sind. Diese sind den Nutzern zumeist nicht einmal verständlich und sie sind nicht in der Lage, das Verhalten des Systems zu antizipieren oder kritisch zu hinterfragen. Die Schwierigkeiten bei der Verantwortungszuschreibung lassen es höchst problematisch erscheinen, Entscheidungen über Leben und Tod von Menschen an Maschinen zu delegieren.

Ein weiterer wichtiger Gesichtspunkt ist, dass Maschinen den Menschen nicht bevormunden, sondern seine Selbstbestimmung stärken sollten. Das lässt sich besonders gut am Beispiel Pflege erläutern. Zum einen sollte jeder selbst entscheiden können, ob er überhaupt von einem künstlichen System gepflegt werden möchte. Zum anderen sollten sich Pflegesysteme flexibel auf die moralischen Standards ihrer Nutzer einstellen, die sich in modernen pluralistischen Gesellschaften unterscheiden.

Ein künstliches System darf seine Nutzer nicht bevormunden, indem es beispielsweise permanent zur Medikamenteneinnahme auffordert oder ihre Patientendaten einfach weitergibt. Vielmehr sollte es in der Lage sein, sich flexibel an die moralischen Wertvorstellungen seiner Nutzer anzupassen, wenn es etwa um die Abwägung des Schutzes der Privatsphäre mit möglichen gesundheitlichen Risiken geht. Die genannten Beispiele verdeutlichen, wie wichtig es ist, Fragen der Transparenz und Verantwortung zu klären. Und vor allem: Bei der Entwicklung von „Artificial Morality“ muss die menschliche Selbstbestimmung immer im Vordergrund stehen.

Illustration: Dmitriip/Shutterstock.com

Porträt Catrin Misselhorn: Martin Stollberg

Alle Artikel

Alle Artikel