Im Zeitalter der Digitalisierung werden immer mehr Prozesse durch Software geregelt. Dabei bleiben die Folgen von Algorithmen oft im Verborgenen. Das Prinzip der Algorithmic Accountability tritt deshalb für eine Rechenschaftspflicht ein: So soll nachvollziehbar werden, welche Entscheidungen wie durch Algorithmen getroffen oder geprägt werden.

Text Lorenz Matzat

Sensoren messen den Verkehr und regeln ihn per Ampeln. Computerprogramme entscheiden in Sekundenbruchteilen, ob sie Aktien verkaufen oder nicht: Der Alltag unserer Gesellschaft ist durchsetzt von intelligenten und automatischen Systemen, die viele kleine Entscheidungen treffen und uns dadurch von Arbeit entlasten. Seit diesem Jahr ist es in Deutschland zulässig, dass die Einkommensteuererklärung komplett automatisiert vom Finanzamt ausgewertet und der Bescheid ohne menschliches Zutun erstellt wird. In Australien verteilt oder verweigert ein Prozess der Automated Border Control das Visum, und die Europäische Union plant Ähnliches. Diese Aufzählung lässt sich leicht fortsetzen: Studienplatzvergaben werden von Software mitentschieden, auch bei der Verteilung von Spenderorganen sind Computer-Rechenroutinen involviert. Die Google-Suchergebnisse und Produktvorschläge von Amazon stammen von Algorithmen.

Selbstredend darf das soziale Online-Netzwerk Facebook bei dieser Aufzählung automatisierter Entscheidungen nicht fehlen. Schließlich stellen dessen Algorithmen längst einen bedeutenden Teil von Öffentlichkeit her, ohne dass uns das bewusst ist: Die Debatten über sogenannte Fake News und Filterblasen gehen nicht zuletzt auf das intransparente Filterverfahren von Facebook zurück, das auswählt, was Nutzer zu lesen und sehen bekommen. In diesem Zusammenhang kommt Algorithmic Accountability ins Spiel. Maßgeblich geprägt hat den Begriff der US-amerikanische Journalismusforscher Nicholas Diakopoulos: Anfang 2014 erschien seine Veröffentlichung Algorithmic Accountability Reporting: On the Investigation of Black Boxes. Dieser Bericht skizziert ein neues Aufgabengebiet für den Journalismus: Rechenverfahren (Algorithmen) wird Rechenschaft (Accountability) abverlangt. Journalisten müssen deshalb die Funktionsweise von Softwaresystemen mit gesellschaftlicher Relevanz als Recherchegegenstand verstehen, um so Transparenz zu schaffen.

WIE MASCHINEN ENTSCHEIDUNGEN TREFFEN

Es gibt vier wesentliche Verfahren, wie per Software Entscheidungen getroffen werden: Priorisieren, Klassifizieren, Herstellung von Zusammenhängen sowie Filterung. Nahezu alle Computerprogramme, die derzeit unter Schlagworten wie Machine Learning im Bereich der Künstlichen Intelligenz vermarktet werden, setzen auf eines oder eine Kombination der genannten mathematischen beziehungsweise statistischen Verfahren. Dabei spielen oft große Datenmengen eine Rolle, die es erlauben, Software anhand bestehender Datensätze zu „trainieren“, um zukünftige Anforderungen erfüllen zu können.

Selbstlernende Algorithmen und große Datensätze bilden eine Black Box, die Algorithmic Accountability notwendig macht. Problematisch ist nicht etwa, dass Aufgaben an Maschinen abgetreten werden. Das kann in vielen Bereichen Erleichterungen für alle Beteiligte liefern, Kosten sparen oder gar faire Ergebnisse liefern, wenn menschliche Stimmungen und Vorurteile aus Auswahlprozessen herausgehalten werden können. Problematisch sind die Aufgaben oder Regeln, die durch Algorithmen abgearbeitet werden sollen. So können etwa Wertungen, Vorurteile oder moralische Einstellungen gezielt oder unterschwellig in Software für selbstlernende Algorithmen einfließen. Ein Beispiel wäre der Komplex „Dieselgate“, bei dem Entscheider und Ingenieure ihre kriminelle Intention durch Software realisieren ließen, um Testverfahren zur Messung von Motorabgasen zu täuschen. Gäbe es verpflichtende Verfahren für Algorithmic Accountability wäre solch ein Betrugsversuch nicht so einfach möglich gewesen. Kritiker fordern deshalb zum Beispiel ein Audit-System, bei dem Softwarecodes und Trainingsdaten überprüft werden sollten, manche wünschen sich gar einen „Algorithmen-TÜV“.

WIE ALGORITHMEN GERICHTSURTEILE PRÄGEN

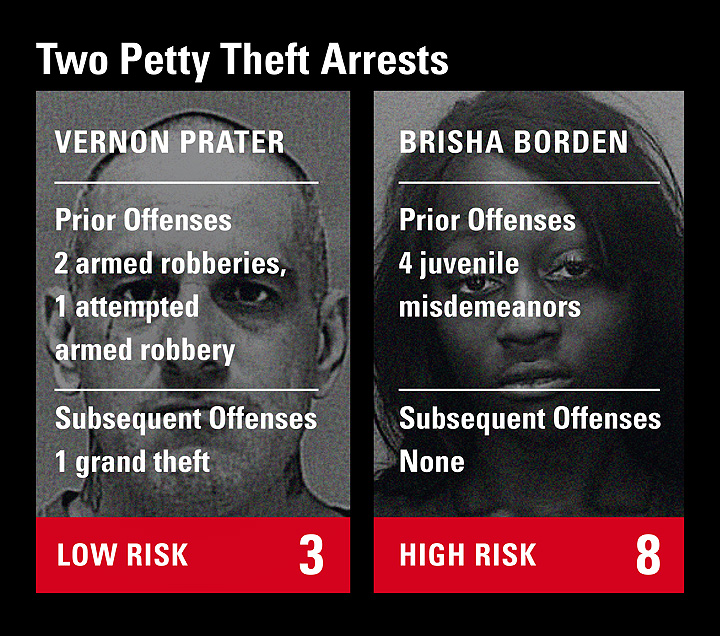

Noch komplizierter sind Prozesse, bei denen Algorithmen automatisch an die Stelle von menschlichen Entscheidungen treten oder diese wesentlich beeinflussen. Zu diesem Bereich des sogenannten Automated Decision Making (ADM) gehören auch Predictive-Analytics-Verfahren, die menschliches Verhalten voraussagen sollen. Ein Beispiel dafür ist die Software „Correctional Offender Management Profiling for Alternative Sanctions“ (COMPAS), die in vielen Bundesstaaten der USA eingesetzt wird. Sie liefert unter anderem Richtern Einschätzungen darüber, inwiefern eine zu verurteilende Person mit hoher Wahrscheinlichkeit in Zukunft ein Gewaltverbrechen begehen könnte. Das US-amerikanische Recherchebüro Pro Publica hat die Software im vergangenen Jahr untersucht und belegt, wie Algorithmen juristische Entscheidungen ungerechter machen können (Serie Machine Bias).

Pro Publica erlangte über eine Informationsfreiheitsanfrage die Risikoeinschätzungen zu mehr als 18.000 Personen, die 2013 und 2014 in einem Landkreis von Florida durch COMPAS bewertet wurden: Nur etwa zwanzig Prozent derjenigen, von denen COMPAS vorhersagte, dass sie in Zukunft ein Gewaltverbrechen ausüben würden, taten es bislang tatsächlich. Auch wenn alle möglichen Kriminalitätsarten und Verstöße – inklusive Fahren ohne Führerschein – hinzugenommen wurden, lagen nur für etwa sechzig Prozent Vergehen vor. Außerdem prognostizierte die Software für US-Amerikaner schwarzer Hautfarbe fälschlicherweise fast doppelt so oft wie für Weiße, dass sie rückfällig werden würden.

Das COMPAS-Beispiel zeigt die umstrittenen möglichen Konsequenzen von Entscheidungsprozessen, die auf ADM-Verfahren basieren. Die Software-Entwickler von COMPAS behaupteten zwar, die Analyse von Pro Publica sei falsch. Ihre Berechnungsmethoden wollte die Firma Northpointe allerdings nicht offenlegen. Schon diese mangelnde Transparenz nährt Zweifel am Einsatz entsprechender Software bei Justizverfahren, die über menschliche Schicksale entscheiden können. So lässt sich auch nicht klären, wie es zur rassistischen Diskriminierung durch algorithmische Verhaltensvoraussagen für Menschen verschiedener Hauptfarbe kam. Das Machine-Bias-Beispiel macht deutlich, warum Datensätze und Algorithmen, auf denen ADM-Systeme basieren, offengelegt beziehungsweise zugänglich gemacht werden müssen.

WIE SOFTWARE DIE FREIHEIT BEDROHT

In Deutschland ist der Einsatz von solcher „Predictive“ Software bei Strafverfahren noch nicht erlaubt. Doch ist unklar, in welchen staatlichen Verwaltungen und anderen Bereichen Software zumindest Entscheidungen vorbereitet, die die persönliche Freiheit Einzelner berühren könnten. Zählt die Software, die Hartz-IV-Bescheide ausrechnet, schon dazu? Was ist mit Kreditwürdigkeitsverfahren (Schufa etc.)? Zwar ist die bereits geforderte Kennzeichnungspflicht für ADM-Prozesse ein sinnvoller Schritt und die ab 2018 gültige EU-Datenschutzgrundverordnung enthält dazu einen Passus. Doch das Wissen darüber, ob ein Bürger einer automatisierten Entscheidung ausgesetzt war, garantiert nicht, dass sie rechtsstaatlichen Verfahren genügt oder diskriminierungsfrei ist. Auch eine Offenlegung von Softwarecodes reicht nicht aus. Damit wäre vielleicht einer Transparenz genüge getan. Allerdings können Softwaresysteme so komplex sein, dass ohne beispielsweise die Trainingsdatensätze (siehe COMPAS) nicht nachvollzogen werden kann, wie sie funktionieren. Insofern sollte die Forderung bei ADM nicht Transparenz, sondern Nachvollziehbarkeit lauten.

Der Vorschlag, dass den Betroffenen bei automatisierten Entscheidungen deren Gründe erläutert werden müssen, weist in die richtige Richtung. Das ist allerdings nicht immer praktikabel: Wenn beispielsweise ein autonomes Fahrzeug „entscheiden“ würde, jemanden zu überfahren, um jemand anderen zu schützen, nutzt so eine Erklärung wenig. So wundert es nicht, dass diese Art von ethischen Fragen zu den Konsequenzen des automatisierten Fahrens in jüngster Zeit eine breitere Öffentlichkeit fand. Denn es zeigt eindrücklich, dass es beim Thema ADM nicht nur um abstrakte Vorgänge geht, die sich auf einem Bildschirm im sozialen Online-Netzwerk oder in einem Amtsbrief niederschlagen. Vielmehr haben durch Algorithmen automatisierte Verfahren – auch hinsichtlich der zunehmenden Automatisierung von Arbeit – unmittelbare Konsequenzen in der physischen Welt.

Bis die Politik für ADM-Prozesse eine geeignete Regulierung und möglicherweise entsprechende Aufsichtsinstitutionen geschaffen hat, bleiben Gesellschaft und Individuum im digitalen Zeitalter auf das Prinzip der Algorithmic Accountability angewiesen. Die Wirkungen und Nebenwirkungen von Algorithmen müssen sichtbar und öffentlich diskutiert werden. Algorithmic Accountability kann dabei für die nötige Transparenz, Nachvollziehbarkeit und Rechenschaftspflicht sorgen. Investigative Recherche im Zusammenspiel mit den Methoden des Datenjournalismus sind dafür unverzichtbar.

Al|go|rithlmus

Substantiv [der]

Eindeutige Handlungsvorschrift zur Lösung eines Problems, die so exakt formuliert ist, dass sie von Maschinen nach einem standardisierten Muster abgearbeitet werden kann. Ziel ist ein in Computer-Codes programmiertes, beliebig multiplizierbares Handeln, basierend auf den Vorgaben seiner Schöpfer.

Pre|dic|tive Ana|ly|tics

Substantiv [die]

Bereich der Datenanalyse (Data Mining), der sich mit der Vorhersage von Ereignissen oder von wahrscheinlichem menschlichen Verhalten auseinandersetzt. Zu diesem Zweck werden Daten gesammelt, die anhand statistischer Modelle in Prognosen umgewandelt werden.

Foto: rosepistola.de

Shutterstock.com: Login, Irina Bg

Grafik: © ProPublica

Porträt: privat

Alle Artikel

Alle Artikel