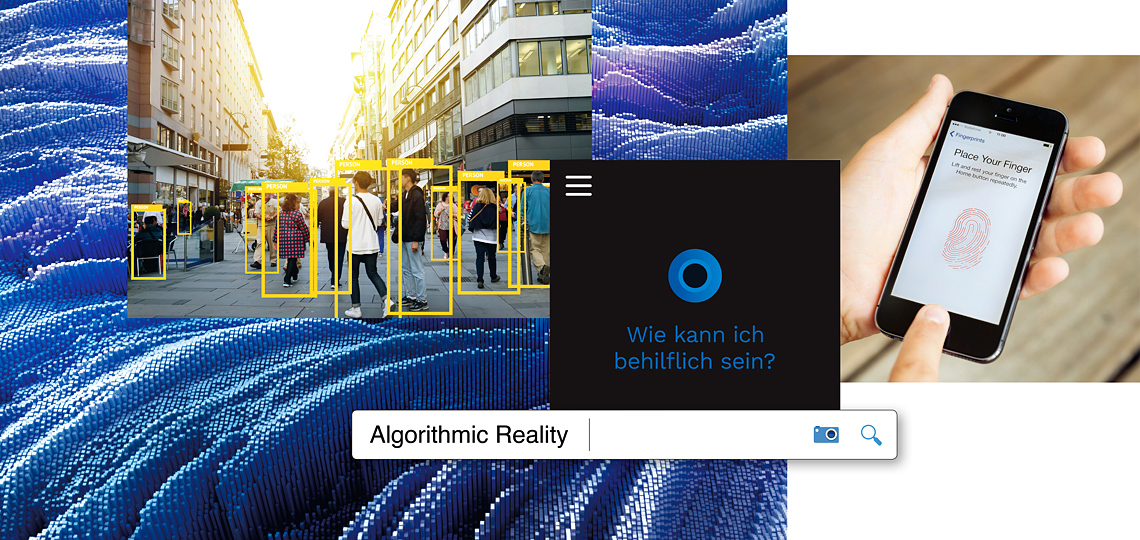

Künstliche Intelligenz (KI) wird unser Leben und die Medien verändern. Noch aber existieren Probleme und Missverständnisse. Erste journalistische Projekte zeigen Potenzial, Risiken und Nebenwirkungen.

TEXT Matthias Kurp

Es war einmal ein norddeutscher Chefredakteur, der wollte eine neue Nachrichten-App ausprobieren: so etwas ganz Modernes mit Algorithmen, Künstlicher Intelligenz, verknüpft mit dem Internet der Dinge. „Wir vermitteln Ihnen den richtigen Inhalt zur richtigen Zeit“, versprach die App, „wir trainieren unsere Algorithmen darin, die Interessen und Nutzungsgewohnheiten jedes einzelnen Nutzers zu verstehen.“ Wie schön! Eine App, die einfach weiß, wann man welche Nachrichten lesen, hören oder sehen möchte. Dem Chefredakteur kam das gerade recht, schließlich wollte er die aktuelle Nachrichtenlage stets im Blick haben und immer auf dem Laufenden sein, was die Konkurrenz schreibt. Er scrollte sich also jeden Morgen durch die News-Inhalte der App, las die Titel der Nachrichtenartikel, die kurzen Teaser. Doch die Nachrichten wurden immer weniger – bis er eines Tages seine App öffnete und staunte: keine neuen Nachrichten! Nun weiß jeder Chefredakteur, dass es keinen Tag ohne Nachrichten gibt. Was also war geschehen?

Das Beispiel zeigt eine der typischen Herausforderungen der Künstlichen Intelligenz: Missverständnisse zwischen Mensch und Maschine. Marco Maas muss ein wenig grinsen, wenn er über solche Pannen redet. Die News-App xMinutes, zu deren Schöpfern er gehört, befindet sich noch in der Beta-Phase. „Solche Probleme findet man nur durch ausführliche Tests. Man benötigt halt echte Nutzer, um eine solche Entwicklung auf Herz und Nieren zu testen.“ Des Rätsels Lösung: Zwischen dem Chefredakteur und der App hatte es ein Missverständnis gegeben. Der Algorithmus lernt aus der Interaktion der Nutzer und deren Verhalten: Klickt der Leser einen Text an, scheint er ihn zumindest interessant zu finden. Bleibt er gar einige Minuten auf der Seite, bestärkt das den Algorithmus darin, diesem Nutzer in Zukunft ähnliche Inhalte anzubieten. Der Chefredakteur hingegen klickte nie etwas an. Ihm genügten die Headlines. Für den Algorithmus hieß das schlicht: kein Interesse! Also blieb das App-Display irgendwann leer.

Solche xMinutes-Fehler sind inzwischen längst behoben. Die Entwickler helfen der KI hier und da mit einigen Regeln nach, die das Ergebnis verbessern. Während Entwickler früher aber alles, was ein Computer leisten sollte, manuell programmieren mussten, können Algorithmen heute selbst dazulernen, indem sie Schlüsse ziehen aus Trainingsdaten, Messergebnissen und Feedback. Künstliche Intelligenz beginnt also nicht erst dort, wo der Mensch überhaupt nicht mehr eingreift, sondern immer dann, wenn – teils von Menschen unterstützt – selbstlernende Systeme beteiligt sind.

„Es gibt wenige, die sich ernsthaft mit Journalismus und maschinellem Lernen beschäftigen“, urteilt Maas. Noch scheint die klassische Medienbranche wenig experimentierfreudig – was ein Fehler sein kann. Warum? Systeme wie Google Now erfüllen eine ähnliche Funktion wie beispielsweise xMinutes: Sie kennen den Nutzer und seine Aktivitäten, sie empfehlen Artikel und vieles andere, sie sammeln deutlich mehr Daten – und sie stellen in der Konsequenz eine mögliche Bedrohung für die Geschäftsmodelle von Fernsehen, Hörfunk und Verlagen dar. xMinutes versteht sich als Plattform, die aktuell mit 35 Medienpartnern zusammenarbeitet und deren Inhalte verteilt. Die App nutzt die Sensoren des Smartphones, um zu erfassen, in welcher Situation sich dessen Besitzer gerade befindet. Ist er auf dem Weg zur Arbeit mit öffentlichen Verkehrsmitteln? Dann sind kurze Nachrichtenhappen vielleicht richtig für ihn. Ist er auf dem heimischen Sofa angekommen, ist eventuell eine ausführliche Zusammenfassung einzelner Geschehnisse interessant, im Zug ein Video, im Auto ein Audio-Inhalt. „Journalismus muss sich in diese Richtung neu erfinden“, lautet Maas‘ Überzeugung.

WIE ALGORITHMEN LERNEN

Das zögerliche KI-Engagement der Medienbranche mag auch an praktischen Problemen liegen, die Künstliche Intelligenz mit sich bringt. Um das zu verstehen, lohnt sich ein Blick auf die Funktionsweise von Algorithmen, die überwacht oder unüberwacht lernen können. Überwachtes Lernen wird unter anderem für Klassifikationsaufgaben genutzt („Ist eine Katze auf einem Foto oder nicht?“). Grundlage dafür sind Trainingsdaten, anhand derer der Algorithmus auf Vorgabe eines Menschen lernt, was das richtige Ergebnis ist („Auf diesen tausend Bildern ist eine Katze, auf diesen tausend nicht.“). Hat das System für alle eventuell vorkommenden Fälle genügend Trainingsdaten, soll es daraus selbst lernen, fremde Bilder zu erkennen.

Allerdings führt der Begriff überwachtes Lernen in die Irre. Denn dieses Lernen ist weit weniger zu kontrollieren, als der Begriff suggeriert. Die Künstliche Intelligenz beurteilt nämlich selbst, welche Kriterien wichtig sind für die Unterscheidung. „Deshalb ist es zentral, dass der Trainingsdatensatz repräsentativ ist für die Art von Daten, die man vorhersagen will“, weist Fred Hamprecht, Professor für Maschinelles Lernen an der Universität Heidelberg, auf mögliche Fehlerquellen hin. So kursiert etwa in Forscherkreisen das Beispiel eines Systems, das darauf trainiert wurde, Panzer auf Bildern zu erkennen. Der Trainingsdatensatz bestand aus Werbebildern des Panzer-Herstellers und aus anderen Fotos, auf denen kein Panzer zu sehen war. Die Folge des selbstlernenden Algorithmus: Das System identifizierte nicht etwa die Panzer, sondern filterte stattdessen Bilder heraus, auf denen die Sonne schien, weil eine weitere Gemeinsamkeit der Fotos schönes Wetter war. „Falls das Beispiel nicht wahr ist, ist es zumindest schön erfunden“, kommentiert Hamprecht.

Oft lassen sich Fehler von selbstlernenden Algorithmen kaum feststellen. Vor allem die neuen Verfahren des maschinellen Lernens, allen voran das derzeit boomende Deep Learning, sind zwar sehr gut darin, Muster in großen Mengen unstrukturierter Daten zu finden, doch der Weg ihrer Entscheidungsfindung bleibt für Menschen ein Rätsel. Deep Learning bezeichnet eine Lernmethode künstlicher neuronaler Netze, bei denen die Funktionsweise des menschlichen Gehirns nachgeahmt wird: Die Netze bestehen aus mehreren Lagen mit einer festzulegenden Anzahl an Neuronen, deren Verbindungen sich verstärken oder abschwächen, abhängig von den „Erfahrungen“ (Trainingsdaten etc.), die ein solches Netz macht. Angesichts der Vielschichtigkeit und wachsender Rechenkapazitäten können solche Netze große Datenmengen verarbeiten. Aber: „Man kann bei neuronalen Netzen schwer nachvollziehen, wie sie zu einer Entscheidung kamen“, schränkt Hamprecht ein.

BLACK BOX & BIG-DATA-KORRELATIONEN

KI-Algorithmen-Systeme gleichen oft einer Art Black Box. Daraus resultierende Gefahren sind beim unüberwachten Lernen möglicherweise noch größer. Dabei bekommt der Algorithmus keine Trainingsdaten und keinen Hinweis auf das gewünschte Ergebnis, sondern soll Strukturen oder Korrelationen in Datenmengen erkennen. So sollen beispielsweise ungewöhnliche Ereignisse, sogenannte Outlier, gefunden werden. Das wird unter anderem angewendet, um Hackerangriffe auf Computernetzwerke anhand auffällig anderer Online-Anfragen zu erkennen. Die Aufgabe für den Algorithmus lautet dann: Finde heraus, was typische Ereignisse sind, und sage mir, was nicht typisch ist. Der zweite typische Anwendungsfall für unüberwachtes Lernen sind Clusteranalysen, also die Suche nach „natürlichen“ Gruppen in Daten mit ähnlichen Eigenschaften. Diese Verfahren sind beispielsweise geeignet, um Cliquen in sozialen Online-Netzwerken zu identifizieren oder Kunden, die ähnliche Kaufinteressen („Kunden wie Sie interessierten sich auch für...“) haben.

Das sogenannte Clustering bietet viele Möglichkeiten. Beim Projekt News-Stream etwa arbeitet das Fraunhofer Institut für Intelligente Analyse- und Informationssysteme (IAIS) mit der Internetagentur Neofonie, der Deutschen Presse-Agentur (dpa) und der Deutschen Welle zusammen: Ein Algorithmus soll herausfinden, welche Themen das Tagesgeschehen bestimmen. Existieren in aktuellen Artikeln von Online-Nachrichtenseiten Muster und Gemeinsamkeiten, wird daraus auf Relevanz und Nachrichtenwerte geschlossen. Semantisch „verstanden“ aber werden die Inhalte dabei nicht. „Nachrichten beinhalten unendlich viele verschiedene Themen – so weit ist die Technik noch nicht“, sagt Fraunhofer-Projektleiter David Laqua. Immerhin: dpa nutzt ein News-Stream-Tool, das zeigt, ob Teile von dpa-Artikeln in Medien vorkommen, und der Deutschen Welle dient das System zur Konkurrenzbeobachtung.

ÜBERWACHTES MASCHINEN-LERNEN

Für die Personalisierung von Medieninhalten kommen meist überwachte Lernverfahren zum Einsatz, bei denen Systeme durch Nutzerdaten „trainiert“ werden. So bietet der Algorithmus von xMinutes nach und nach immer passendere News-Angebote. Ähnliches geschieht bei Facebook. Was dort im Newsfeed erscheint, wird mittels Künstlicher Intelligenz aufgrund von Nutzerprofilen individuell angepasst: Welche Freunde haben einzelne Nutzer? Was interessiert sie? Mit wem interagieren sie in welcher Form? Und welche Links haben sie bisher angeklickt? Forscher warnen vor der Filterblase, die so entstehen kann: Dank dieser individualisierten Selektion von Nachrichten erreicht den Nutzer nicht mehr das gesamte Spektrum. Er könnte das Gefühl bekommen, die ganze Welt teile seine Meinung – Perspektiven von Andersdenkenden werden ausgeblendet. Die Forschung zu solchen Filterblasen- oder Echokammer-Effekten steht erst am Anfang.

Die Personalisierung von Nachrichten ist im Medienbereich ein großes Thema: Zahlreiche Apps versprechen, Nachrichten an den jeweiligen Leser anzupassen – doch kaum eine hat bislang besondere Relevanz erlangt, viele wurden wieder eingestellt. Der Axel Springer Verlag startete 2016 für die Applikation Upday eine Kooperation mit Samsung. Die App ist auf den neuen Samsung-Galaxy-Smartphones vorinstalliert und präsentiert nach Angaben von Springer mehr als zehn Millionen Nutzern aus 16 europäischen Ländern personalisierte Inhalte. Das Upday-System lernt daraus, was Nutzer lesen. Die App lotst die Leser vom Teaser direkt auf die Seite der mehr als tausend Medienpartner. Upday ist auch ein Versuch, sich Erlöse zurückzuholen, die unter anderem via Facebook Instant Articles verlorengehen. Facebook beteiligt Verlage zwar an den Werbeeinnahmen, kassiert aber mit, ohne eigene Inhalte finanzieren zu müssen. Außerdem geben Verlage bei Instant Articles Kundendaten und auch die Personalisierung aus der Hand: Welche Inhalte der Facebook-Algorithmus schließlich welchem Nutzer anbietet, das bleibt unklar. Upday hingegen basiert nicht nur auf KI-Mechanismen. „Wir verhindern, dass der Nutzer in seiner eigenen Filter Bubble verschwindet“, versichert Chefredakteur Jan-Eric Peters. Deshalb kuratiert eine Redaktion täglich Top-News, die alle Nutzer zu sehen bekommen.

POTENZIALE DER PERSONALISIERUNG

Algorithmen an sich sind weder gut noch böse. Entscheidend ist die Art ihrer Anwendung, die beispielsweise auch gegen Filter-Bubble-Effekte helfen könnte: So lasse sich beispielsweise analysieren, welche Medien ein Nutzer bevorzugt, um ihm bewusst eine komplementäre Ergänzung anzubieten, kündigt Marco Maas für xMinutes an. Informiere sich ein Nutzer über Syrien, könne er sowohl eher konservative Inhalte von welt.de als auch linke von taz.de bekommen. Aber machen die Nutzer das mit? Folgen sie Empfehlungen für Inhalte, die sie eigentlich nicht mögen? Im Freundes- und Familienkreis hat Maas gute Erfahrungen gemacht: „Die Leute lasen a) mehr, b) andere Dinge und c) zu neuen Themen.“

Personalisierung könnte sogar so weit gehen, Artikel in verschiedener Form zu publizieren, sagt Martin Hoffmann, Geschäftsführer der Resi Media UG: „Warum sind alle Artikel für alle Menschen gleich geschrieben?“ Schließlich gibt es verschiedene Bildungshintergründe. Hoffmann hat die Resi-App entwickelt, die für 15- bis 25-jährige Nutzer Nachrichten in Form von Kurz-Dialogen wie bei WhatsApp präsentiert – von Menschen geschrieben. Personalisierung findet er bis zu einem gewissen Grad unproblematisch. „Man darf es aber nicht übertreiben“, warnt er.

Mit einer anderen Art der Distribution von Nachrichten beschäftigt sich Swoozy, ein Projekt des Deutschen Forschungszentrums für Künstliche Intelligenz (DFKI): Dabei analysiert ein KI-Programm via Bild- und Texterkennung, was ein Nutzer gerade im Fernsehen sieht, und bietet dazu passend am Bildschirmrand zusätzliche Online-Informationen an. „Wir wollen weg vom App-Paradigma“, erläutert Projektleiter Matthieu Deru, also weg davon, dass Nutzer während des Fernsehens allerlei Apps und Browserfenster auf dem Smartphone öffnen, um sich zusätzliche Infos zu suchen. Für TV-Programmanbieter könne das interessant sein, weil eine neue Art des Product Placement möglich werde, argumentiert der DFKI-Forscher. Wer den Button „Shop it“ drückt, kann beispielsweise das abgebildete Kleid eines Promis kaufen. „Das ist besser als normale Werbung, denn nur wer sich dafür interessiert, bekommt sie angezeigt“, verweist Deru auf geringe Streuverluste. Personalisierte Werbung ist eine der großen Hoffnungen der Medienbranche. Schließlich müssen sich die neuen smarten Produkte auch bezahlt machen.

INTELLIGENTE RECHERCHE

KI-Geschäftsmodelle stehen noch ganz am Anfang. Die meisten der erwähnten Projekte werden von verschiedenen Geldgebern gefördert, vom Bundesforschungsministerium oder von Googles News Initiative. Zu den vielversprechendsten Anwendungen gehören zurzeit KI-Konzepte für journalistische Recherchen. Nicht zuletzt die Veröffentlichungen rund um die Panama Papers zeigten, wie aus großen Mengen unstrukturierter Daten Geschichten und Skandale gefiltert werden können. Die Panama Papers, anhand derer Journalisten – unter anderem der Süddeutschen Zeitung – in einem internationalen Journalistenkonsortium Steuerschlupflöcher aufgedeckt haben, bestanden aus 11,5 Millionen Dokumenten. Kein Mensch hätte die 2,6 Terabyte Daten von Hand durchsuchen können. Die Journalisten nutzten deshalb verschiedene Anwendungen des maschinellen Lernens, die ihnen halfen, die Dokumente lesbar zusammenzufügen, zu strukturieren und schließlich Netzwerke zwischen den beteiligten Personen und Organisationen zu visualisieren.

Die Gründer von Deutschlands erster Fact-Checking-Nachrichtenagentur wafana, die vom Media Lab Bayern unterstützt wird, entwickeln zurzeit das Social Listening Tool Crowdalyzer. Dabei spüren Algorithmen nachrichtenrelevanten User Generated Content auf und überprüfen die Glaubwürdigkeit des Urheber-Accounts, um so Themenpräferenzen der Nutzer und Trends vorauszusagen. Auf Künstliche Intelligenz bei der Recherche setzt auch die Initiative new/s/leak, an der unter anderem der Spiegel beteiligt ist. Das System, dessen Entwicklung von der Volkswagenstiftung gefördert wurde, identifiziert in großen Datenmengen, die üblicherweise bei Leaks vorkommen, automatisch Namen von Personen, Organisationen und Orten als sogenannten Entitäten und visualisiert die Korrelationen zwischen ihnen. Noch aber fehlt es dabei an Genauigkeit. Selbst bei hochwertigen Textsorten wie Zeitungs- oder Wikipedia-Artikeln erkenne Künstliche Intelligenz „mindestens acht Prozent der Personen, zwanzig Prozent der Firmen und 15 Prozent der Orte nicht richtig“, berichtete Mitentwickler Chris Biemann von der Universität Hamburg im Interview mit der Volkswagenstiftung. „Das muss man einfach hinnehmen.“ Wichtig sei deshalb, dass das Tool direkt einen Zugang zu den Originaldokumenten mitliefere, damit die Journalisten es überprüfen könnten.

NUR ZU ACHTZIG PROZENT FEHLERFREI

Fehlende Genauigkeit sei auch der Grund dafür, dass etwa die Resi-Entwickler ihre App händisch mit Nachrichten füttern und eben nicht von einem Algorithmus, klärt Hoffmann auf: „Im Journalismus geht es um extreme Genauigkeit, KI funktioniert nur zu achtzig Prozent fehlerfrei. Das entscheidende im Journalismus sind aber genau die zehn bis zwanzig Prozent, die übrig bleiben.“ KI eignet sich deshalb nicht als vollautomatischer News-Aggregator. Größere Potenziale sieht Hoffmann für die Redaktionsinfrastruktur: „Man kann Autoren auf Themen aufmerksam machen, bevor sie große Wellen schlagen. Oder man kann vorhersagen, welcher Artikel gut bei Facebook laufen wird.“

Künstliche Intelligenz kann dabei helfen, Inhalte aufgrund bestimmter Kriterien zu filtern. In diese Richtung experimentieren auch die Macher der Schweizer 12-App, die Smartphone-Nutzern jeden Mittag nach eigener Aussage „die zwölf relevantesten Artikel“ aus zwölf Schweizer Zeitungen und Magazinen sowie der Süddeutschen Zeitung präsentiert. Nur: Was ist relevant? Auch wenn in der Selbstdarstellung viel Wert darauf gelegt wird, dass ein „eigenes Redaktionsteam“ die Texte „von Hand verlese“, hilft offenbar ein Algorithmus, der den Erfolg von Artikeln vorhersagt. „Bei einer Flut von Artikeln dient er als intelligenter Filter, der die besten Kandidaten auswählt“, sagte der Data Scientist von Tamedia, Marcel Blattner, im Interview mit dem Online-Portal persönlich.com. Der sogenannte RoboEditor lerne dabei aus Daten der Vergangenheit: Wie viele Leser haben welche Artikel angeklickt? Welche wurden viel geteilt, welche als gut bewertet? Ersetzen soll der RoboEditor die Redakteure aber nicht: „Für die Selektion, was dann wirklich publiziert wird, braucht es Menschen.“

MENSCHLICHE KONTROLLINSTANZ

An einer anderen Ecke des globalen Nachrichtenstroms setzt ScatterBlogs an: Die Ausgründung der Universität Stuttgart hilft Journalisten, Meldungen über Ereignisse in Echtzeit aus Twitter zu extrahieren. Algorithmen können dabei echte Ereignisse von Gerüchten unterscheiden, indem sie die Quelle (Nutzer und Standort) verifizieren und aus dem Kontext auch bei mehrdeutigen Ausdrücken den Sinn ableiten. So kann das System beispielsweise eine „Bombe“ als Ausdruck für einen besonders guten Treffer im Fußball unterscheiden von einem terroristischen Anschlag. Solche Kontexterkennung ist noch schwierig für Algorithmen. Doch ScatterBlogs verweist auf erste Erfolge: „Wir wollen Ereignisse möglichst anhand der ersten zwei oder drei Tweets erkennen“, erklärt Dennis Thom – denn nur diese stammten sicher vom Ort des Geschehens, danach breite sich die Info aus. Die Nachrichtenagenturen dpa und AFP testen den Service bereits. Die Visualisierung unter anderem anhand einer Weltkarte zeigt dem Nutzer, wie sich eine bestimmte Nachricht ausbreitet. Informationen über den Original-Tweet, über die Quelle und deren Hintergrund machen es möglich, dass jeder Mensch stets die Ergebnisse des Algorithmus überprüfen und nachvollziehen kann.

Ohne menschliche Kontrollinstanz, das ist ein breiter Konsens unter den Medienschaffenden, wird Künstliche Intelligenz zur Black Box und zum Risiko. Forscher arbeiten aktuell an selbstlernenden Systemen, die ihre Entscheidungen entweder erklären können oder eine Möglichkeit bieten, diese nachzuvollziehen – damit KI und Menschen zusammenarbeiten können. Fehlende Erklärbarkeit und mangelnde Transparenz gelten aktuell als die problematischsten Schwächen selbstlernender Algorithmen. Durch Künstliche Intelligenz Menschen ersetzen? Das sei sicherlich eines der größten Missverständnisse, merkt Fraunhofer-Forscher Laqua an: „Oft wird angenommen, dass man mit KI Mitarbeiter einsparen kann, aber gerade bei kreativen Tätigkeiten ist das nicht der Fall.“ Künstliche Intelligenz wird kaum Menschen ersetzen, aber sie kann Menschen helfen, mit wachsenden Datenmengen klug umzugehen.

Künst|li|che In|tel|li|genz (KI)

Substantiv [die]

Teilgebiet der Informatik, das sich mit der Automatisierung intelligenter Problemlösungen beschäftigt. Die KI-Forschung versucht, menschliche Wahrnehmung und menschliches Handeln durch Maschinen nachzubilden. Ziel ist die Schaffung einer menschenähnlichen Intelligenz.

Deep Lear|ning

Substantiv [die]

Lernmethode künstlicher neuronaler Netze, bei denen die Funktionsweise des menschlichen Gehirns nachgeahmt wird: Die Netze bestehen aus einer Menge untereinander über Kommunikationskanäle verknüpfter Verarbeitungseinheiten (Neuronen).

Big Da|ta

Ohne Artikel

Große, komplexe und sich schnell vergrößernde Datenmenge, die mit Hilfe von Computern auf Korrelationen untersucht werden kann, um Strukturen und Zusammenhänge festzustellen. Im deutschen Sprachgebrauch wird auch der Begriff Massendaten verwendet.

MEDIENTAGE MÜNCHEN 2017

Die Medientage München, die vom 24. bis 26. Oktober unter dem Motto „Media – Trust – Machines“ im Internationalen Congress Center München stattfinden, bieten gleich mehrere Veranstaltungen zum Thema Künstliche Intelligenz an:

Mittwoch, 25. Oktober:

- Autmate or Die – Wie AI und Tech den Newsroom voranbringen

- Democratizing Artificial Intelligence

- Können Maschinen kreativ sein – wohin steuert die künstliche Intelligenz?

Donnerstag, 26. Oktober:

- Talk to the Machine! Chatbots, Messenger und Sprachassistenten im Marketing

- Journalism Summit – Media and the Machines: The Future of Journalism

Weitere Informationen online: www.medientage.de

Foto: rosepistola.de

iStock.com/enot-poloskun

Zapp2Photo/Shutterstock.com

iStock.com/Mlenny Creative Commons CC0 (2)

Porträt: Helena Ebel

Alle Artikel

Alle Artikel